딥러닝 모델의 성능을 극대화하고 싶으신가요? 오늘은 딥러닝 분야에서 혁신적인 기법으로 주목받고 있는 ‘드롭아웃(Dropout)’에 대해 자세히 알아보겠습니다. 드롭아웃은 과적합을 방지하고 모델의 일반화 능력을 향상시키는 강력한 도구입니다. 이 글에서는 드롭아웃의 개념부터 실제 구현 방법, 그리고 효과적인 활용 전략까지 상세히 다루겠습니다.

딥러닝 드롭아웃의 개념과 중요성

드롭아웃은 2012년 Hinton 교수팀에 의해 제안된 정규화 기법입니다. 이 기법의 핵심 아이디어는 학습 과정에서 신경망의 일부 뉴런을 임의로 비활성화시키는 것입니다. 이를 통해 모델은 특정 뉴런에 과도하게 의존하지 않고, 더 robust한 특성을 학습할 수 있게 됩니다.

드롭아웃의 중요성은 다음과 같습니다:

- 과적합 방지: 복잡한 모델일수록 훈련 데이터에 과도하게 맞춰지는 경향이 있는데, 드롭아웃은 이를 효과적으로 방지합니다.

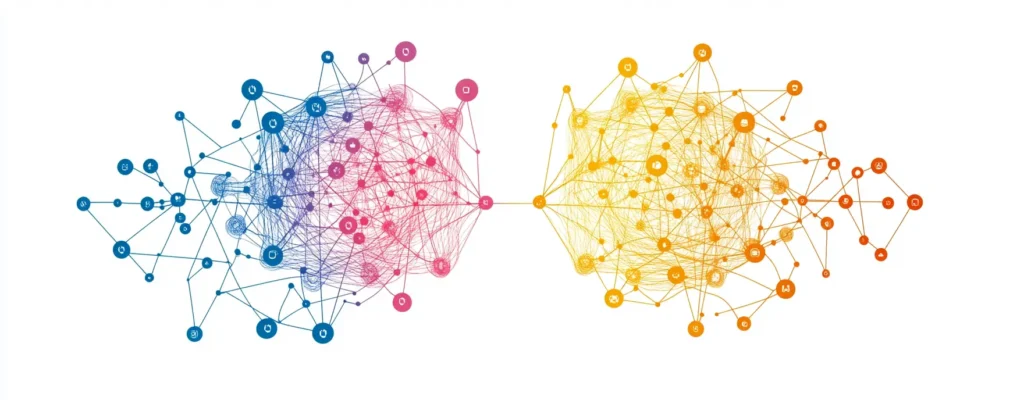

- 앙상블 효과: 서로 다른 구조의 여러 네트워크를 학습시키는 효과를 냅니다.

- 계산 효율성: 학습 시 일부 뉴런만 사용하므로 계산량을 줄일 수 있습니다.

드롭아웃의 작동 원리: 과적합 방지와 일반화 능력 향상

드롭아웃은 어떻게 과적합을 방지하고 일반화 능력을 향상시킬까요? 그 원리를 살펴보겠습니다.

- 랜덤 비활성화: 각 학습 단계마다 일정 비율의 뉴런을 무작위로 ‘탈락’시킵니다. 보통 50%의 드롭아웃 비율을 사용합니다.

- 상호의존성 감소: 특정 뉴런에 과도하게 의존하는 것을 막아, 더 robust한 특성을 학습하게 됩니다.

- 노이즈 주입 효과: 학습 데이터에 노이즈를 주입하는 효과가 있어, 모델의 일반화 능력이 향상됩니다.

- 앙상블 학습: 매 학습 단계마다 다른 구조의 네트워크를 학습하는 효과를 냅니다. 이는 여러 모델의 예측을 평균 내는 앙상블 기법과 유사한 효과를 줍니다.

파이썬으로 구현하는 드롭아웃 레이어

이제 실제로 파이썬을 사용해 드롭아웃을 구현해보겠습니다. 여기서는 TensorFlow/Keras를 사용한 예시를 보여드리겠습니다.

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Dropout

model = Sequential([

Dense(128, activation='relu', input_shape=(784,)),

Dropout(0.5),

Dense(64, activation='relu'),

Dropout(0.5),

Dense(10, activation='softmax')

])

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

이 코드에서 Dropout(0.5)는 50%의 뉴런을 무작위로 비활성화하는 드롭아웃 레이어를 의미합니다. 일반적으로 입력층과 은닉층 사이, 그리고 은닉층들 사이에 드롭아웃을 적용합니다.

드롭아웃 적용 시 주의사항과 최적의 사용법

드롭아웃을 효과적으로 사용하기 위해서는 몇 가지 주의사항을 알아야 합니다:

- 드롭아웃 비율 선택: 일반적으로 0.2에서 0.5 사이의 값을 사용합니다. 너무 높으면 학습이 어려워지고, 너무 낮으면 효과가 미미할 수 있습니다.

- 테스트 시 비활성화: 추론(테스트) 단계에서는 드롭아웃을 사용하지 않습니다. 대신 모든 뉴런의 출력을 드롭아웃 비율만큼 스케일링합니다.

- 레이어별 다른 비율: 네트워크의 깊이에 따라 다른 드롭아웃 비율을 적용할 수 있습니다. 일반적으로 입력층에 가까울수록 낮은 비율을, 출력층에 가까울수록 높은 비율을 사용합니다.

- 다른 정규화 기법과 병행: L1/L2 정규화, 배치 정규화 등 다른 정규화 기법과 함께 사용하면 더 좋은 성능을 얻을 수 있습니다.

실제 프로젝트에서의 드롭아웃 활용 사례

드롭아웃은 다양한 딥러닝 프로젝트에서 성공적으로 활용되고 있습니다. 몇 가지 사례를 살펴보겠습니다:

- 이미지 분류: CNN(Convolutional Neural Network)에서 완전 연결 계층에 드롭아웃을 적용하여 ImageNet 등의 대규모 데이터셋에서 우수한 성능을 보였습니다.

- 자연어 처리: LSTM이나 GRU 같은 순환 신경망에서 드롭아웃을 적용하여 언어 모델링, 기계 번역 등의 태스크에서 과적합을 줄이고 성능을 향상시켰습니다.

- 음성 인식: 음성 인식 모델에서 드롭아웃을 사용하여 노이즈에 대한 robustness를 높이고 일반화 성능을 개선했습니다.

- 추천 시스템: 협업 필터링 기반 추천 시스템에서 드롭아웃을 적용하여 과적합을 방지하고 추천 정확도를 높였습니다.

드롭아웃과 다른 정규화 기법의 비교

드롭아웃 외에도 다양한 정규화 기법이 있습니다. 각각의 특징을 비교해보겠습니다:

- L1/L2 정규화: 가중치의 크기에 페널티를 부여하는 방식입니다. 드롭아웃과 달리 모든 뉴런을 사용하지만, 가중치를 작게 유지합니다.

- 배치 정규화: 각 레이어의 입력을 정규화하는 기법입니다. 학습 속도를 높이고 초기화에 덜 민감하게 만듭니다.

- 데이터 증강: 입력 데이터에 변형을 주어 학습 데이터를 늘리는 방법입니다. 드롭아웃이 모델 구조를 변경하는 반면, 데이터 증강은 입력 데이터를 다양화합니다.

- 조기 종료: 검증 오차가 증가하기 시작하면 학습을 멈추는 기법입니다. 드롭아웃과 함께 사용하면 더욱 효과적입니다.

드롭아웃의 장점은 구현이 간단하고 계산 비용이 적다는 점입니다. 또한 모델 구조를 동적으로 변경하여 앙상블 효과를 낸다는 특징이 있습니다.

딥러닝 모델 성능 향상을 위한 드롭아웃 튜닝 전략

마지막으로, 드롭아웃을 효과적으로 튜닝하는 전략을 알아보겠습니다:

- 그리드 서치: 다양한 드롭아웃 비율(예: 0.1, 0.3, 0.5)을 시도해보고 최적의 값을 찾습니다.

- 레이어별 다른 비율 적용: 네트워크의 깊이에 따라 다른 드롭아웃 비율을 적용해봅니다.

- 학습률 조정: 드롭아웃을 사용하면 일반적으로 더 높은 학습률을 사용할 수 있습니다. 학습률을 함께 튜닝해보세요.

- 모니터링: 검증 세트의 성능을 주의 깊게 모니터링하며 과적합의 징후를 관찰합니다.

- 앙상블과 결합: 여러 드롭아웃 모델의 예측을 앙상블하여 더 높은 성능을 얻을 수 있습니다.

드롭아웃은 딥러닝 모델의 성능을 크게 향상시킬 수 있는 강력한 도구입니다. 이 글에서 소개한 개념과 전략들을 활용하여 여러분의 프로젝트에서 드롭아웃을 효과적으로 사용해보시기 바랍니다. 끊임없는 실험과 튜닝을 통해 최적의 설정을 찾아내는 것이 중요합니다. 딥러닝의 세계에서 드롭아웃을 마스터하여 더 뛰어난 모델을 만들어보세요!